“Su Internet” dice un bastardino a un altro mentre armeggia con la tastiera “nessuno sa che sei un cane”. La famosa vignetta di Peter Steiner, pubblicata sul New Yorker nel luglio del 1993, è stata per anni l’idea stessa della Rete: libertà e anonimato. Oggi, va da sé, di quel cane sappiamo tutto.

ANTEFATTO. IL COMPLOTTO – Il 9 novembre del 2016 il mondo occidentale si sveglia con un nuovo leader. Nessun sondaggio, nessun giornale né think tank ha profetizzato la sua vittoria. Al contrario. Come ha fatto Donald Trump a vincere? O meglio: come diavolo ha fatto a vincere uno come Donald Trump? Le elezioni erano truccate? È stata colpa di Hillary Clinton e del suo mailgate? Oppure sono stati i guai con le macchinette elettroniche per il voto? No. Sono stati i russi. Nemmeno dentro il suo stesso staff – siamo ai giorni delle rivelazioni del libro Fire and Fury – c’era qualcuno disposto a scommettere che questo buffo, arrogante, ricco cafone arancione sarebbe stato il successore di Barack Obama.

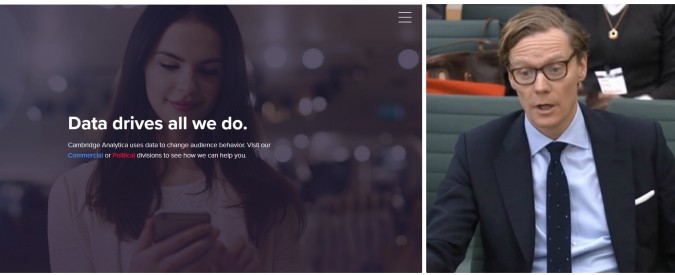

Una persona sola, quando in Inghilterra è già pomeriggio, scommette che il merito sia suo. Si chiama Alexander James Ashburner Nix, ha 41 anni e siede su una miniera d’oro. Nix è il ceo di Cambridge Analytica, giovane società che gestisce i cosiddetti big data, e ha il coraggio di intestarsi un merito (o una tragedia) di non poco conto: avere profilato e targetizzato 220 milioni di americani, cioè tutti gli adulti con diritto di voto.

Profilare e targetizzare: gli elettori di un determinato quartiere, area, contea o Stato vengono stratificati per censo, orientamento politico, propensione al voto, acquisti, comportamenti. Tutto è raccolto e organizzato in grandi database. I messaggi politici da sottoporre, a quel punto, se non personalizzati, sono altamente strutturati: nel tuo quartiere le fogne non vanno? Colpa del governatore democratico. Sono aumentati i furti? Lottiamo per il tuo diritto ad avere armi. E via così: alla rappresentanza sul territorio si sostituisce la politica on demand. Decine di migliaia di messaggi diversi dicono una cosa sola: conosco il tuo problema e ti darò ciò di cui hai bisogno. Solo per il terzo dibattito con Hillary Clinton, lo staff di Trump ha testato 175 mila diversi messaggi.

Attraverso lo studio psicometrico di cinque tratti fondamentali degli elettori, ricostruiti attraverso la raccolta di quanti più dati possibili su ciascuno di essi, Nix sostiene di essere in grado di dire non solo chi siamo, ma anche cosa ci può cambiare e smuovere. È l’evoluzione di un metodo noto e a suo tempo contestato, denominato Ocean. Per chi andasse in cerca di complotti è l’acme: Cambridge Analytica ha già lavorato alla profilazione degli elettori per il referendum sulla Brexit, sul cui esito pendono accuse e dubbi di infiltrazioni straniere. A sua volta è finanziata da imprenditori iperconservatori come Robert Mercer e ha, a quel tempo, il controverso Steve Bannon come vice-presidente. E chi lavora insieme alla cerchia ristretta di Trump quando arriva l’offerta di informazioni compromettenti sulla Clinton? Chi contatta Julian Assange nel tentativo di creare un database delle mail della ex segretaria di Stato? Sempre Nix.

Cambridge Analytica è una controllata della ben più ramificata Strategic Communication Laboratories, Scl, i cui interessi spaziano dalle elezioni in Ucraina fino a quelle in Nigeria, per spingersi alla contropropaganda in chiave anti-Russia in Lettonia con soldi Nato. Nata nel ’93 come società con scopi civili, dalla metà degli anni Duemila sviluppa una serie di programmi per la Difesa che vanno dalla “guerriglia psicologica” alla “presa di possesso temporanea dei mezzi di comunicazione”, in scenari degni di James Bond. Solo che qui la Spectre c’è davvero, e si cela dietro Aleksandr Kogan. Un personaggio suggestivo. Nel 2014, due anni prima che Trump arrivi alla Casa Bianca, si presenta nei laboratori di psicometria dell’università di Cambridge dove un brillante ricercatore, Michal Kosinski, sta sperimentando l’applicazione del metodo Ocean attraverso Facebook e i social network. Il metodo è tanto sbalorditivo quanto spaventoso: Kosinski sostiene di poter descrivere un individuo grazie alla sommatoria di una settantina di like con una precisione tra il 75 e l’85%. Orientamento sessuale, politico, propensione al consumo, patologie mediche di base: il nostro profilo e le nostre interazioni sono un libro aperto nelle mani della scienza sociale.

Kogan si presenta come intermediario per la Scl e chiede di poter accedere ai dati della ricerca. Kosinski si lascia corteggiare un po’, ma alla fine rifiuta, sconvolto dal pensiero che quegli orientamenti possano essere non più solo studiati, ma deviati. Kogan scompare dalla storia, Kosinski scoprirà più avanti che ha registrato una società legata a Scl. Ma di lui nessuna traccia: Cambridge Analytica e Scl negano qualsiasi nesso tra la loro attività e il metodo di Kosinski. E quando l’inglese Guardian e lo svizzero Das Magazin – cui si deve la ricostruzione della storia – riescono a trovare Kogan, l’uomo si trova a Singapore e ha cambiato nome. Ora è Aleksandr Spectre: il Dr. Spectre.

4 MARZO, L’ITALIA AL VOTO – Cosa impedisce alle aziende come Cambridge Analytica di sbarcare in Italia per diffondere i propri messaggi mirati e targetizzati? A dire il vero la società ha avuto un primo approccio con il nostro Paese nel 2012, incaricata di una ricerca su un non meglio precisato “partito italiano in fase di ripresa” i cui ultimi successi “risalivano agli anni 80”.

Resta la domanda: quanto è realistico lo scenario americano in Italia? Le differenze che ci separano dagli Stati Uniti sono sostanziali. Dal punto di vista della privacy i due ordinamenti si reggono su assunti opposti: negli Usa è consentito diffondere ciò che non è stato esplicitamente negato (opt-out). Tanto che l’intero discorso, prendendo a prestito un concetto dello scrittore Jonathan Franzen, si potrebbe ribaltare in: “Privacy è non essere raggiunti da informazioni che non hai chiesto”.

In Italia il meccanismo funziona al contrario: senza il sì (opt-in) non si va avanti. Ma questo non significa che i partiti non potrebbero disporre di una mole di dati imponente che noi stessi riveliamo con le nostre azioni quotidiane. Facebook e gli altri social, certo, ma anche Google, conoscono ogni comportamento dei propri utenti. Il monopolio de facto del motore di ricerca copre le attività di 39,1 milioni di italiani che usano Internet. Mentre quelli connessi sui social sono “solo” 31 milioni. Nel frattempo, il mercato dei big data è cresciuto fino a valere 1,1 miliardi nell’anno appena concluso (dati dell’Osservatorio del Politecnico di Milano). Ma a farla da padrone per ora sono le banche (28%), l’industria (24%) e le società di telecomunicazione (14%).

SPAM! – E la politica? Non pervenuta. “Non ci ha mai cercato”, dice il professor Carlo Vercellis che dell’Osservatorio del Politecnico di Milano è il capo. Il suo gruppo di lavoro si occupa anche di machine learning, hate speech detection, “estrazione dei sentimenti”. Tutti temi che stanno modificando il modo di agire delle aziende – basta scorrere l’elenco dei committenti dell’osservatorio – ma non quello della politica. “Sicuramente come Paese siamo indietro. Come se l’uso elettorale si riducesse al bombardamento via Twitter, in modo casereccio più che analitico. I partiti non hanno né i soldi né la cultura per agire su questo terreno”. Eppure potrebbero: le tecnologie per il data-mining sono le stesse utilizzate per l’estrazione dei bitcoin tanto in voga: “Abbiamo potenze di calcolo incredibili grazie alle schede grafiche di ultima generazione”.

Nella tradizionale dicotomia tra apocalittici e integrati, Vercellis è sicuramente appartenente alla seconda categoria: molto meglio governare i big data piuttosto che subirli. Ma quando si parla di applicazione alla politica storce il naso: “Ad Amazon non interessa lei come persona, ad Amazon interessa che lei veda i prodotti che altre persone come lei hanno comprato. Quando si parla del voto la questione diventa molto più pericolosa”. Già: chi custodisce? Chi controlla? Chi paga la raccolta? A voler pensar male, con i dati si può fare tutto: ricostruire via gps gli spostamenti di un individuo o infangarne la credibilità rivelando le sue ossessioni pornografiche o infedeltà coniugali, ad esempio. Che poi è, potere a parte, ciò da cui sono scaturiti il mailgate e il Russiagate.

Ma se pensate che il modo per “difendersi” sia l’inattività in Rete, allora dovrete rinunciare anche a ogni tessera sconto, a ogni carta punti o membership, a ogni acquisto on line e anche alla vostra casella di posta. Tutto raccoglie dati. E così si torna alla domanda di partenza. Perché i partiti italiani non fanno esattamente quel che ha fatto Trump? Una parola: soldi. I dati anagrafici sono facilmente ottenibili, quelli sulla partecipazione politica sono già a disposizione. E su questo si basa storicamente l’approccio all’elettore. Quel che manca è una struttura in grado di aggregare i dati in maniera omogenea: tanto per tornare a Trump, lo sforzo di Cambridge Analytica è costato 15 milioni di dollari, all’interno di una struttura da 400 milioni. Relativamente poco rispetto all’intera campagna elettorale. Moltissimo per una serie di strumenti on line.

“Fino alle scorse regionali” spiega il sondaggista Roberto Weber di Ixè “i partiti potevano contare su circa quattro euro per ogni singolo voto. Oggi quelle cifre non ci sono più”. Anche Weber, come Vercellis, non pensa che i big data potranno influenzare il voto. Non questo almeno: “Le tecniche di targetizzazione esistono da cinquant’anni, ma da noi non hanno mai preso piede”. Perché? Per Weber oltre ai soldi c’è una unicità tutta sociale: “Siamo sempre stati artigiani e partigiani, lo siamo anche nella politica. La partecipazione attiva scende? Non la partigianeria. I gruppi chiusi su Facebook replicano le sezioni di partito”. A essere romantici è come dire che gli italiani sono unici nel loro essere sempre tutti allenatori della nazionale. Ma nella pratica significa che il groviglio delle opinioni politiche diventa sempre più inestricabile. E se la politica è più povera e gli elettori sempre più polarizzati anche nel distacco – suggerisce Weber – il ruolo di supplenza lo svolge la vecchia Tv pubblica. Affollata come mai prima da proclami e polemiche.

Un altro caso americano, la rielezione di Obama nel 2012, spiega in quale ritardo si trovi l’Italia rispetto – prima ancora che alla profilazione – alla gestione dei big data. Il professor David Nickerson, che della campagna democratica è stato “direttore degli esperimenti”, racconta nel suo Political Campaigns and Big Data che uno degli sforzi principali per la rielezione di Obama è stata la creazione di un mostro chiamato Narwhal. Letteralmente narvalo, o “balena cadavere”, altro non è che una base di dati provenienti da archivi di ordine inferiore, combinati, uniformati tra loro e resi disponibili alle migliaia di volontari democratici in giro per il Paese attraverso una app telefonica che li guidava di casa in casa, di telefono in telefono, nel modo più efficiente e raffinato possibile. Questa efficienza ha permesso di concentrare lo sforzo verso gli elettori con maggiore propensione al voto piuttosto che spendere risorse ed energie verso i sostenitori avversari o i totalmente disinteressati, come dimostra in maniera lampante il grafico sui contatti con gli elettori in Ohio in tre tornate presidenziali.

La campagna di Barack Obama, del resto, è una pietra miliare delle strategie elettorali. Al Narvalo hanno lavorato esperti di Twitter, Google, Facebook, Quora, Craiglist. Cioè il meglio delle startup e dell’high tech made in Usa. Complessivamente Obama ha raccolto donazioni da più di mezzo milione di persone, per un totale di 191 milioni di dollari. L’uomo più ricco della politica italiana, Silvio Berlusconi, tanto per capirsi, ha affidato i social network a Francesco Facchinetti. Solo nell’ufficio “analytics” di Obama, capitanati da un bizzarro nerd con il piercing di nome Harper Reed, hanno lavorato invece 54 persone, sedici ore al giorno, sette giorni su sette per tutta la durata del rush finale. E se all’inizio della sfida il Narvalo “pesava” soltanto 10 terabyte, alla fine aveva raggiunto il peso record di 50 terabyte. Il repubblicano Mitt Romney del resto, per non essere da meno aveva varato il suo contro-software. Con un nome di battaglia che ne tradiva la voracità: progetto Orca.

PER CHI VOTANO FB E BIG G – Ben lontani dal poter confermare o smentire che dietro il proliferare di fake news ci sia la mano armata degli hacker di Vladimir Putin o una piccola società in cerca di guadagni virali, quel che si può dire con evidenza scientifica è che colossi come Facebook e Google sono in grado di orientare il voto. Soprattutto quello degli indecisi.

Il primo per motivi legati al mezzo: per ragioni facilmente comprensibili, sui social network i contenuti più condivisi sono quelli di minore spessore e complessità. Il che regala un vantaggio competitivo a messaggi semplici, diretti, accattivanti e divertenti. Il populismo, in buona sostanza, ha una corsia preferenziale nella circolazione delle idee. Quel che a un elettore con un’ideologia strutturata appare ridicolo, per un elettore acerbo può essere simpatico o accattivante. È la stessa cosa che avvenne nel tempo della dominazione della televisione generalista con personaggi come Maurizio Gasparri, la cui popolarità è stata più accresciuta che danneggiata dalle parodie di Neri Marcorè.

Per quanto riguarda Google, il meccanismo è semplice e non necessita di demiurghi né complotti. Il professor Robert Epstein, psicologo dell’American Institute for Behavioral Research and Technology, sostiene che il motore di ricerca possa “determinare più del 25% delle elezioni nazionali”. Epstein e colleghi hanno studiato per anni l’effetto che le informazioni positive hanno sugli elettori indecisi che fanno ricerca in proprio per orientarsi tra i candidati.

Risultato: indipendentemente da quale fosse il candidato di riferimento, l’accesso a informazioni positive attraverso il motore di ricerca aumentava la possibilità di votare per X in media del 48%. Epstein ha chiamato questo valore Vote Manipulation Power: potere di manipolazione del voto. I critici di Epstein hanno opposto due obiezioni fondamentali. Prima obiezione: che cosa succede se tra le informazioni positive ne vengono aggiunte di negative? Seconda obiezione: i cittadini non vivono in un ambiente di laboratorio. Cosa succede a chi è soggetto a una varietà di informazioni anche involontarie?

Per risolvere il primo quesito, il gruppo di lavoro di Epstein ha inserito tra i risultati della simulazione anche notizie e giudizi negativi sui politici X e Y, scoprendo che questo non faceva altro che aumentare l’effetto di quelle positive. Perché? Perché il cittadino malfidente, messo di fronte all’eccezione negativa, è portato a ritenere che tutto il complesso di informazioni raccolte sia realmente neutrale e veritiero.

Rispondere all’obiezione numero due è stato più complesso ma ugualmente efficiente. Epstein non ha fatto altro che portare il suo metodo fuori dal laboratorio, sperimentandolo in elezioni reali. Come atteso, il Vote manipulation power è sceso, dal 48% al 24% di media. Ma non scomparso.

Trasportato nelle elezioni americane, ma anche e soprattutto italiane, dove un punto percentuale può decidere la governabilità o meno del Paese, il dubbio instillato da Epstein rappresenta una minaccia alla credibilità dei motori di ricerca. Sollecitata sul tema da Wired Usa, Google ha ovviamente replicato che interferire con le elezioni sarebbe puro autolesionismo. È la logica del macellaio (digitale): se la carne che ti do fa schifo non tornerai a comprarla. Resta il fatto che nelle ultime presidenziali americane Big G aveva, al pari di Facebook e Twitter, suoi uomini dentro tutti gli staff dei candidati. Con l’eccezione (perdente) di Hillary Clinton.

GLI INTERESSI DI INTERNET – C’è un ultimo elemento fin qui totalmente sorvolato: non esistono soltanto gli interessi elettorali della politica su Internet. Esistono, e sono corposi, gli interessi di Internet nei confronti della politica. Già nel 2012, ad esempio, Google prendeva parte attiva alle proteste contro il cosiddetto Sopa-Pipa, la legge americana sulla pirateria contro cui si addensavano molti dubbi di limitazione della libertà di parola. A chi cercava informazioni sul testo, il motore di ricerca rispondeva con un banner nero sul proprio logo e un invito a combattere la censura. “Interferenza” interessata e quindi legittima, ma rivelatrice di un assunto – in questo caso pubblico, condiviso, esplicito e manifesto – ignorato dai più: il motore di ricerca non è solo un servizio planetario gratuito, persegue anche finalità proprie. È un soggetto, non un oggetto. Con interessi che si concretizzano in altri atti meno sbandierati come le cifre investite anno dopo anno per le attività di lobbying verso l’Unione europea, cresciute del 500% nell’arco di cinque anni. Rapporti mai troppo buoni, sia per Big G che per le altre grandi società globali come Facebook o Amazon, che combattono sullo stesso fronte battaglie legislative e guerre fiscali.

Senza arrivare alle richieste drastiche portate avanti soprattutto in Germania e in Inghilterra di espropriare e nazionalizzare i grandi aggregatori di dati, vale la pena di ricordare che i big data sono cresciuti in maniera esponenziale nell’ultimo decennio, tanto che si stimava che nel solo 2012 fossero stati immagazzinati più dati che nei 5 mila anni precedenti. E il volume cresce del 90% ogni due anni. Oggi l’unità di misura per calcolarli è lo zettabyte e filosofi della Rete come Luciano Floridi hanno stimato che tra il 2013 e il 2020 si arrivi a immagazzinarne 44. Prendete il vostro hard disk da un terabyte e moltiplicate il suo contenuto 44 miliardi di volte.

Il tema di chi amministra questa massa di informazioni è fondamentale per dirimere tra il potere spirituale del “Dio Google” e quello temporale dei governi. In questa corsa, le Pubbliche amministrazioni italiane sono entrate tardi. Il Commissario per la Agenda Digitale del governo, Diego Piacentini, ha annunciato solo a gennaio la strategia italiana per rendere comunicanti tra loro i database delle amministrazioni dello Stato. Strategia che parte dalla creazione di un Data & Analytics framework, in sperimentazione per tutto il 2018.

Oggi, “la memoria immemore del digitale”, dice Floridi nelle sue conferenze, è monopolio dei motori di ricerca. Secondo il filosofo, si tratta di una memoria incerta perché incerte e mutevoli sono le risposte alle nostre domande. Il risultato è un “eterno presente”: nell’Era digitale “tutto si scrive e si cancella di continuo”. Di qui a George Orwell il passo è breve. “Chi controlla il passato controlla il futuro. Chi controlla il presente controlla il passato”, scriveva in 1984. Oggi, parafrasa Luciano Floridi, “chi controlla le domande dà forma alle risposte e chi controlla le risposte dà forma alla realtà”.

P.s. Intorno alla casa londinese di George Orwell, al 27b di Canonbury Square, a Islington, oggi ci sono 32 telecamere a circuito chiuso che lavorano 24 ore su 24.

Articolo Precedente

Siria, Assad tra i militari sul fronte della Ghouta: ‘Sono gli eroi del nostro esercito’