Capitoli

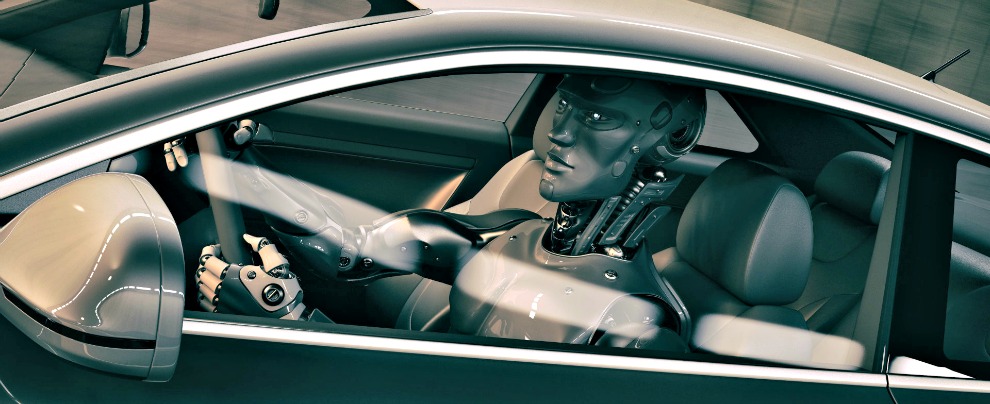

Guida autonoma, macchine che guidano da sole comandate da "cervelli" che imparano da soli. Ci sono rischi? - 2/2

Una ricerca del MIT mette in evidenza come il processo di apprendimento dell'intelligenza artificiale (AI) che guiderà le self driving car del futuro spesso non è assoggettabile al controllo di ingegneri e progettisti. Bensì si evolve in maniera autonoma, con tutto ciò che può comportare in termini di sicurezza

La capacità misteriosa di ragionamento dei veicoli Nvidia in questione (ma nei campi militare e medico la ricerca è ancora più avanzata), evidenzia dunque “il” problema incombente che comporta una “comprensione” autonoma: la tecnologia AI sottostante, l’apprendimento profondo, si dimostra molto potente nel risolvere situazioni complicate di comprensione (riconoscimento vocale, traduzione, interpretazione delle immagini) ed il suo sviluppo porta ad affidare a queste tecnologie sempre più azioni e compiti, tra cui diagnosi di malattie pericolose, elaborazione di decisioni in campo economico e militare ed altro ancora, in grado di trasformare radicalmente industrie e società. Ma serve rendere tale apprendimento più comprensibile ai suoi stessi creatori e, dunque, affidabile nei confronti degli utenti. Questo è uno dei motivi per cui le auto di Nvidia sono ancora sperimentali.

L’Intelligenza Artificiale, insomma, si prepara a penetrare profondamente nel nostro mondo, ma prima bisogna mettere paletti ben precisi per mantenerne il controllo. Il sito del MIT evidenzia, infatti, come esistano già profonde riflessioni della ricerca per considerare un diritto giuridico fondamentale poter interrogare ogni sistema di intelligenza artificiale riguardo a come esso maturi le proprie decisioni. A partire dall’estate 2018, l’Unione Europea ad esempio potrebbe esigere che le aziende siano in grado di fornire agli utenti una spiegazione per le decisioni prese dai sistemi automatizzati. Cosa che potrebbe essere impossibile, sollevando questioni da capogiro. Con l’avanzare della tecnologia, si potrebbe presto attraversare la soglia oltre la quale l’impiego di Intelligenza Artificiale richieda un vero e proprio atto di fede.

Certo, proseguono al MIT, l’uomo non può sempre spiegare i suoi processi di pensiero, ma sa trovare ad intuito il modo di dare fiducia e “pesare” le altre persone. Questo sarà possibile per macchine che pensano e prendono decisioni in modo diverso da noi? A che livello ci aspettiamo di poter interagire con qualcosa che opera in modi imprevedibili ed imperscrutabili al suo stesso creatore? Torniamo al nodo cruciale: potrebbe essere parte della stessa natura di intelligenza il fatto che solo una porzione di essa sia basata su spiegazioni razionali, mentre un’altra è puro istinto. Il dilemma, comunque, rimane: vogliamo e possiamo correre il rischio di affidarci alla “natura” delle macchine intelligenti?